-

求职秘籍

站-

热门城市 全国站>

-

其他省市

-

-

400-636-0069

400-636-0069

小职

2020-12-15

来源 :慧都大数据https://blog.csdn.net/qq_27005679/article/det

阅读 702

评论 0

小职

2020-12-15

来源 :慧都大数据https://blog.csdn.net/qq_27005679/article/det

阅读 702

评论 0

摘要:本篇总结了最重要的大数据Hadoop面试问题以及具体问题的详细解答,无论是大数据行业的新手还是经验丰富的,都需要大数据基础知识。希望对于大数据的学习或者面试有所帮助。

本篇总结了最重要的大数据Hadoop面试问题以及具体问题的详细解答,无论是大数据行业的新手还是经验丰富的,都需要大数据基础知识。希望对于大数据的学习或者面试有所帮助。

在之前的文章中,我们总结了10个大数据面试入门级问题以及大数据面试中级问题,大家是否有收获呢?如果还没有看的小伙伴,可以直接复习

《50个大数据面试题第一篇:10个大数据面试入门级问题》

《50个大数据面试题第二篇:10个大数据面试中级问题》

开始学习吧!

依然是10个已经在大数据行业工作的老司机们面试时的问题及建议答案,话不多说,赶紧开始今天的学习。

Hadoop是最受欢迎的大数据框架之一,如果您正在进行Hadoop面试,请为Big Data Hadoop准备这些基本级别的面试问题。无论您是要参加Hadoop开发人员还是Hadoop Admin面试,这些问题都将对您有所帮助。

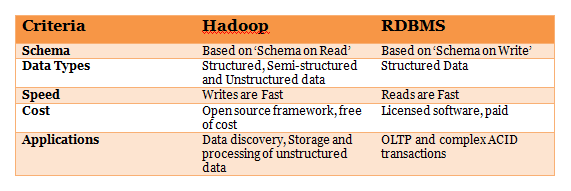

21. 解释Hadoop和RDBMS之间的区别。

Hadoop和RDBMS之间的区别如下 :

22. Hadoop中常见的输入格式是什么?

以下是Hadoop中常见的输入格式 -

文本输入格式 - Hadoop中定义的默认输入格式是文本输入格式。

序列文件输入格式 -要读取序列中的文件,请使用序列文件输入格式。

键值输入格式 -用于纯文本文件(分成行的文件)的输入格式是键值输入格式。

23. 解释Hadoop的一些重要特性

Hadoop支持大数据的存储和处理。它是处理大数据挑战的最佳解决方案。Hadoop的一些重要功能是 -

开源 - Hadoop是一个开源框架,这意味着它是免费提供的。此外,允许用户根据他们的要求更改源代码。

分布式处理 - Hadoop支持数据的分布式处理,即更快的处理。Hadoop HDFS中的数据以分布式方式存储,MapReduce负责数据的并行处理。

容错力 - Hadoop具有高度容错能力。默认情况下,它为不同节点的每个块创建三个副本。这个数字可以根据要求改变。因此,如果一个节点发生故障,我们可以从另一个节点恢复数据。节点故障的检测和数据的恢复是自动完成的。

可靠性 - Hadoop以独立于计算机的可靠方式在群集上存储数据。因此,存储在Hadoop环境中的数据不受机器故障的影响。

可伸缩性 - Hadoop的另一个重要特性是可伸缩性。它与其他硬件兼容,我们可以轻松地将新硬件分配给节点。

高可用性 -即使在硬件故障后,也可以访问存储在Hadoop中的数据。如果硬件发生故障,可以从另一个路径访问数据。

24. 解释Hadoop运行的不同模式

Apache Hadoop运行在以下三种模式 :

独立(本地)模式 -默认情况下,Hadoop以本地模式运行,即在非分布式单节点上运行。此模式使用本地文件系统执行输入和输出操作。此模式不支持使用HDFS,因此用于调试。在此模式下,配置文件不需要自定义配置。

伪分布式模式 -在伪分布式模式下,Hadoop就像独立模式一样在单个节点上运行。在此模式下,每个守护程序都在单独的Java进程中运行。由于所有守护进程都在单个节点上运行,因此主节点和从节点都有相同的节点。

完全分布式模式 -在完全分布式模式下,所有守护进程都在不同的单个节点上运行,从而形成一个多节点集群。主节点和从节点有不同的节点。

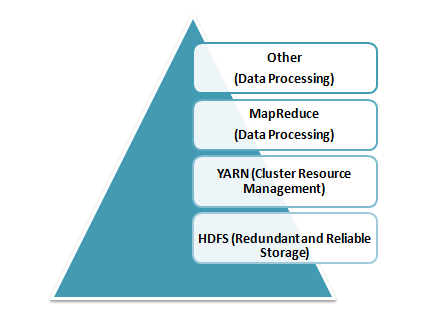

25. 解释Hadoop的核心组件

Hadoop是一个开源框架,用于以分布式方式存储和处理大数据。Hadoop的核心组件是 -

HDFS(Hadoop分布式文件系统) - HDFS是Hadoop的基本存储系统。在商用硬件集群上运行的大型数据文件存储在HDFS中。即使硬件出现故障,它也能以可靠的方式存储数据。

Hadoop的核心组件

Hadoop MapReduce - MapReduce是负责数据处理的Hadoop层。它编写了一个应用程序来处理存储在HDFS中的非结构化和结构化数据。它负责通过将数据划分为独立任务来并行处理大量数据。处理分两个阶段完成Map和Reduce。Map是指定复杂逻辑代码的第一个处理阶段,Reduce是指定轻量级操作的第二阶段处理。

YARN - Hadoop中的处理框架是YARN。它用于资源管理并提供多种数据处理引擎,即数据科学,实时流和批处理。

26. “MapReduce”程序中的配置参数是什么?

“MapReduce”框架中的主要配置参数是:

在分布式文件系统中输入Jobs的位置

在分布式文件系统中输出Jobs的位置

数据的输入格式

数据的输出格式

包含map函数的类

包含reduce函数的类

包含mapper,reducer和驱动程序类的JAR文件

27. HDFS中的块是什么?它在Hadoop 1和Hadoop 2中的默认大小是多少?我们可以改变块大小吗?

块是硬盘中最小的连续数据存储。对于HDFS,块存储在Hadoop集群中。

Hadoop 1中的默认块大小为:64 MB

Hadoop 2中的默认块大小为:128 MB

是的,我们可以使用位于hdfs-site.xml文件中的参数--dfs.block.size 来更改块大小。

28. 什么是MapReduce框架中的分布式缓存

分布式缓存是Hadoop MapReduce框架的一项功能,用于缓存应用程序的文件。Hadoop框架使缓存文件可用于在数据节点上运行的每个map / reduce任务。因此,数据文件可以作为指定作业中的本地文件访问缓存文件。

29. Hadoop的三种运行模式是什么?

Hadoop的三种运行模式如下:

Ⅰ、独立或本地:这是默认模式,不需要任何配置。在此模式下,Hadoop的以下所有组件都使用本地文件系统并在单个JVM上运行 -

NameNode

数据管理部

ResourceManager

节点管理器

II、伪分布式:在此模式下,所有主从Hadoop服务都在单个节点上部署和执行。

III、完全分布式:在此模式下,Hadoop主服务器和从服务器在不同的节点上部署和执行。

30. 在Hadoop中解释JobTracker

JobTracker是Hadoop中的JVM进程,用于提交和跟踪MapReduce作业。

JobTracker按顺序在Hadoop中执行以下活动 :

JobTracker接收客户端应用程序提交给作业跟踪器的作业;

JobTracker通知NameNode确定数据节点;

JobTracker根据可用的插槽分配TaskTracker节点;

它提交了已分配的TaskTracker节点的工作;

JobTracker监视TaskTracker节点;

当任务失败时,会通知JobTracker并决定如何重新分配任务。

关注“职坐标在线”(Zhizuobiao_Online)公众号,免费获取学习视频资料、技术就业咨询。

喜欢 | 0

喜欢 | 0

不喜欢 | 0

不喜欢 | 0

您输入的评论内容中包含违禁敏感词

我知道了

请输入正确的手机号码

请输入正确的验证码

您今天的短信下发次数太多了,明天再试试吧!

我们会在第一时间安排职业规划师联系您!

您也可以联系我们的职业规划师咨询:

版权所有 职坐标-一站式IT培训就业服务领导者 沪ICP备13042190号-4

上海海同信息科技有限公司 Copyright ©2015 www.zhizuobiao.com,All Rights Reserved.

沪公网安备 31011502005948号

沪公网安备 31011502005948号